Как устроен искусственный интеллект и почему всё гораздо проще, чем кажется

Заведующий кафедрой цифровой аналитики и технологий искусственного интеллекта Института информационных технологий и интеллектуальных систем КФУ Александр Тощев выступил с лекцией «ИИ простыми словами – нейросети, CNN/Transformers и SNN» в рамках «Научного экспресса» «Марафона знаний» в Национальной библиотеке РТ.

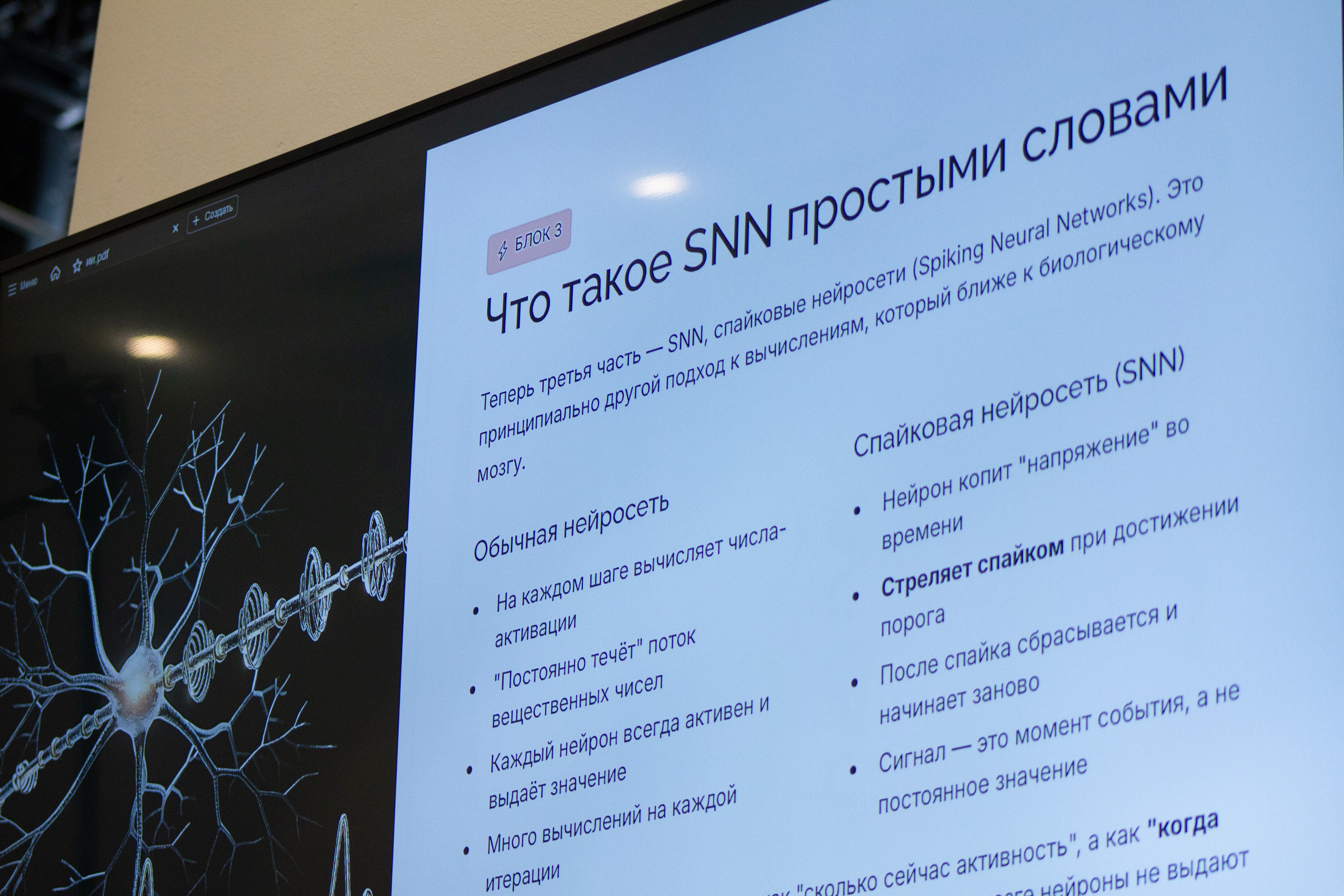

В самом начале лекции Александр Тощев обозначил, что обучение нейросети – это всего лишь поиск минимума ошибок, а не магия. Для примера от привел три основных вида архитектур - CNN, Transformer и SNN. CNN — это свёрточные нейронные сети, разработанные для задач, где важна пространственная структура данных, например, обработка изображений или видео. Transformer же самые популярные и имеют преимущество в обработке последовательностей данных, таких как – текст и музыка. А также есть SNN -спайковые нейросети, за которыми, по мнению эксперта, будущее, ведь они работают через импульсы во времени, прямо как в мозге человека.

«Важная оговорка - ИИ не «понимает» как человек. Он подбирает параметры, чтобы хорошо предсказывать на похожих примерах» - подмечает Александр Тощев.

Задача нейросети – выдать нам некий правильный ответ, для этого мы должны дать ей множество примеров для обучения, мощность для обработки и оптимизировать её. Т.е. создать функцию, которая превратит «вход» в правильный «выход». Нейросети– это очень гибкая функция с множеством настроек. По сути, нужно минимизировать ошибки. Минимизировать разницу между предсказанием и реальностью. Сложность в том, чтобы, кроме точных значений, дать и абстрактное представление для нейросети.

«Если посмотреть на картинки, то они состоят из пикселей. Каждый пиксель можно закодировать в некую математическую формулу, представить его в выражении трёх цветов – красный, зеленый, синий. И тем самым закодировав его в некую матрицу, мы можем обучить, что комбинация пикселей этой матрицы будет являться машиной, человеком или ещё чем-то другим. А всё остальное в нейросети посвящено тому, чтобы нейросеть работала более абстрактно. Где-то мы изначально берём 6 пикселей или 10 и превращаем в 3, чтобы уйти в абстракцию, а не учить ее распознавать каждый пиксель отдельно. Ваша цель здесь придумать именно ту функцию, которая на вашем аппарате данных даст максимально оптимальную функцию потерь.» - рассказал заведующий кафедрой цифровой аналитики и технологий искусственного интеллекта.

То же касается и обучения нейросетей контексту в моделях, которые работают с текстом, а не с картинками. Иначе модель будет запоминать только тренировочные примеры наизусть и ошибаться на новых данных, теряться при смене освещения, другом языке пользователей. А, как мы знаем, ИИ может ошибаться очень уверенно и всегда нужна проверка и валидация в критичных системах.

«Структура данных имеет значение. В картинке важны соседние пиксели и локальные паттерны, в тексте важен контекст и связи между словами, во временных рядах важна последовательность и динамика. Разные архитектуры — это способы подсказать модели структуру мира, чтобы она училась быстрее и эффективнее, требовала меньше обучающих данных, работала стабильнее на новых примерах.» - объясняет Александр Тощева.

Спайковые нейросети - принципиально другой подход к вычислениям, который ближе к биологическому мозгу. В этой архитектуре нейрон копит напряжение во времени, стреляет спайком при достижении порога, после спайка сбрасывается и начинает заново. Сигнал здесь это момент события, а не постоянное значение, информация передается короткими импульсами-спайками. Это дает – энергоэффективность и учёт временной природы данных, если важны задержки, частота и временная динамика, к примеру при обработке нейросигналов. Уже сейчас появляются специализированные чипы, где «событийные вычисления» реализованы на аппаратном уровне максимально эффективно.