Организация многоагентных систем

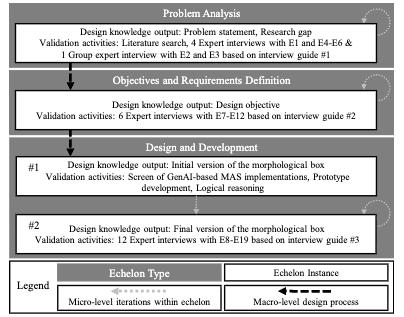

В статье предложен практичный подход к управлению многоагентными системами на базе генеративного ИИ. Авторы рекомендуют задавать агентам четкие правила и узкую специализацию чтобы обеспечить предсказуемость и соблюдение норм. «Оркестровка», которая подходит людям обычно работает и для агентов, так как агенты учатся на человеческих данных и перенимают поведенческие шаблоны. Программных агентов можно разворачивать в большом числе, поэтому выгодно иметь много узкоспециализированных агентов. Авторы подчеркивают, что ожидания и критерии качества следует задавать при «оркестровке». Явные критерии делают результаты более согласованными и упрощают контроль, это делает систему более надежной и удобной в внедрении.

В статье предложен практичный подход к управлению многоагентными системами на базе генеративного ИИ. Авторы рекомендуют задавать агентам четкие правила и узкую специализацию чтобы обеспечить предсказуемость и соблюдение норм. «Оркестровка», которая подходит людям обычно работает и для агентов, так как агенты учатся на человеческих данных и перенимают поведенческие шаблоны. Программных агентов можно разворачивать в большом числе, поэтому выгодно иметь много узкоспециализированных агентов. Авторы подчеркивают, что ожидания и критерии качества следует задавать при «оркестровке». Явные критерии делают результаты более согласованными и упрощают контроль, это делает систему более надежной и удобной в внедрении.

Эмпатичный AI-помощник

Яндекс объявил о разработке новой категории AI-помощников под названием «люмены». Это виртуальные компаньоны для развлечений и повседневных разговоров. Они смогут обсуждать вместе с вами фильмы, музыку и книги, давать советы и поддерживать разговор так, чтобы казаться похожими на реального человека. Производители планируют персонализировать каждого люмена с помощью образов животных, которые отражают характер и интересы пользователя. Сейчас проект находится в стадии тестирования и многие детали персонализации пока скрыты, но компания нацелена на запуск в 2026 году. Идея состоит в том, чтобы перейти от утилитарных ассистентов к эмпатичным спутникам, которые не просто отвечают на команды, но и создают привычку общаться. Это может повысить вовлеченность в сервисы Яндекса и сделать интерфейсы более естественными. При этом важно сохранять прозрачность, уведомлять пользователей о применении ИИ и защищать их данные. Первые тесты покажут насколько удобно и безопасно иметь такого помощника.

Яндекс объявил о разработке новой категории AI-помощников под названием «люмены». Это виртуальные компаньоны для развлечений и повседневных разговоров. Они смогут обсуждать вместе с вами фильмы, музыку и книги, давать советы и поддерживать разговор так, чтобы казаться похожими на реального человека. Производители планируют персонализировать каждого люмена с помощью образов животных, которые отражают характер и интересы пользователя. Сейчас проект находится в стадии тестирования и многие детали персонализации пока скрыты, но компания нацелена на запуск в 2026 году. Идея состоит в том, чтобы перейти от утилитарных ассистентов к эмпатичным спутникам, которые не просто отвечают на команды, но и создают привычку общаться. Это может повысить вовлеченность в сервисы Яндекса и сделать интерфейсы более естественными. При этом важно сохранять прозрачность, уведомлять пользователей о применении ИИ и защищать их данные. Первые тесты покажут насколько удобно и безопасно иметь такого помощника.

Этичность ИИ в судебной системе

Исследование даёт рекомендации по ответственному использованию искусственного интеллекта в судебной практике. ИИ следует применять, как помощника для рутинных задач при сохранении за судьёй права на финальное решение. Системы должны быть прозрачными и объяснимыми, чтобы судьи и адвокаты могли понимать и оспаривать выводы. Нужно публично сообщать: где и как используется ИИ, какие данные используются и как обновляются модели. Перед внедрением требуется оценка воздействия и регулярные проверки на предвзятость и точность. Суды должны вести журналы аудита фиксировать рекомендации ИИ и решения людей, а также назначить ответственных за мониторинг работы системы. Защита данных предполагает минимизацию хранения, строгий контроль доступа и понятные правила удаления. Для доверия общественности нужен простой портал с объяснениями функций и мер защиты. Пилотные проекты и публикуемые аудиты помогут проверить эффект и адаптировать практику.

Исследование даёт рекомендации по ответственному использованию искусственного интеллекта в судебной практике. ИИ следует применять, как помощника для рутинных задач при сохранении за судьёй права на финальное решение. Системы должны быть прозрачными и объяснимыми, чтобы судьи и адвокаты могли понимать и оспаривать выводы. Нужно публично сообщать: где и как используется ИИ, какие данные используются и как обновляются модели. Перед внедрением требуется оценка воздействия и регулярные проверки на предвзятость и точность. Суды должны вести журналы аудита фиксировать рекомендации ИИ и решения людей, а также назначить ответственных за мониторинг работы системы. Защита данных предполагает минимизацию хранения, строгий контроль доступа и понятные правила удаления. Для доверия общественности нужен простой портал с объяснениями функций и мер защиты. Пилотные проекты и публикуемые аудиты помогут проверить эффект и адаптировать практику.

AI пишет код в 1.7 раз хуже, чем человек

AI пишет код в 1.7 раз хуже, чем человек

Отчёт CodeRabbit проанализировал 470 пул реквестов из открытых репозиториев, включая 320 с участием ИИ и 150 написанных людьми. В среднем код от ИИ содержит в 1.7 раза больше ошибок и проблем, чем человеческий код. Логические ошибки встречаются на 75% чаще. Уязвимости появляются от полутора до двух раз чаще. Читаемость падает втрое из-за неудачно выбранных имён переменных и форматирования. Неэффективные операции ввода-вывода обнаружены почти в 8 раз чаще. Авторы объясняют это тем, что моделям не дают контекст проекта и командные правила. Они предлагают простые меры для снижения рисков. Нужно давать ИИ больше контекста и документировать правила проекта. Также стоит включать автоформатирование и линтеры в систему непрерывной интеграции и требовать тесты для сложной логики. Важно усилить сканирование безопасности и иметь чеклисты ревью с акцентом на обработку ошибок и валидацию. Такие шаги помогут сохранить скорость разработки и повысить качество и безопасность кода.

Отказ от старых методов в обучении на основе табличных данных и гиперграфов

Сотрудник китайского университета Циндао опубликовал статью, в которой описан метод HERMES, который помогает моделям забывать ненужные данные в задачах с табличными данными, представленными как гиперграфы. Вместо дорогостоящего переобучения авторы фиксируют исходную модель, как учителя, и обучают новую модель учеником. На сохраняемых данных ученик повторяет поведение учителя. На данных для удаления ученика заставляют давать неопределённые ответы и специально расходиться с учителем, чтобы стирать запоминание. Для удаления столбцов и значений используют контрфактуальные подстановки и требование устойчивых предсказаний, а также учитывают структуру гиперграфа, чтобы не допустить утечек информации. В экспериментах HERMES близок по качеству к переобучению, но работает заметно быстрее и даёт проверяемые сигналы того, что информация действительно забыта.

Сотрудник китайского университета Циндао опубликовал статью, в которой описан метод HERMES, который помогает моделям забывать ненужные данные в задачах с табличными данными, представленными как гиперграфы. Вместо дорогостоящего переобучения авторы фиксируют исходную модель, как учителя, и обучают новую модель учеником. На сохраняемых данных ученик повторяет поведение учителя. На данных для удаления ученика заставляют давать неопределённые ответы и специально расходиться с учителем, чтобы стирать запоминание. Для удаления столбцов и значений используют контрфактуальные подстановки и требование устойчивых предсказаний, а также учитывают структуру гиперграфа, чтобы не допустить утечек информации. В экспериментах HERMES близок по качеству к переобучению, но работает заметно быстрее и даёт проверяемые сигналы того, что информация действительно забыта.

Исследование MIT: ускоряет ли ИИ работу программистов

Исследование MIT: ускоряет ли ИИ работу программистов

Энтузиазм вокруг AI-инструментов для разработки начинает ослабевать. Опрошенные эксперты отмечают растущие разочарования. С одной стороны, ИИ помогает писать более надежный код и решает рутинные задачи, например, создание тестов или объяснение кода новичкам. Это снимает нагрузку с инженеров. Но в сложных проектах, где требуется глубокое понимание, ИИ показывает серьезные ограничения. Его модели часто ошибаются, причем выдают ошибки в красивом, отполированном коде, где их трудно найти, что в свою очередь, создает риски безопасности. Главная проблема в качестве — ИИ способствует накоплению технического долга. Он генерирует запутанный и сложный код, который тяжело поддерживать. Анализ больших проектов ему недоступен из-за ограничений памяти. Объективные тесты показывают, что с ИИ производительность опытных разработчиков может падать.